24 janv. 2026Luke

Guide Careti GLM-4.7-Flash pour l'exécution locale et le déploiement sur site

Démo de GLM-4.7-Flash exécuté localement avec Ollama sur une RTX 3090 et mises à jour de l'interface Thinking UI. Découvrez des cas d'utilisation sur site pour résoudre les problèmes de sécurité et de coûts.

Suite à l'intérêt récent pour le modèle GLM-4.7-Flash-Latest, nous avons reçu de nombreuses demandes concernant la prise en charge par Careti des LLM locaux et des environnements sur site (On-Premise). Nous avons préparé une vidéo montrant le fonctionnement réel.

1. Pourquoi GLM-4.7-Flash ?

GLM-4.7-Flash est un leader dans la classe des 30B, une nouvelle option de déploiement légère (30B-A3B MoE) qui équilibre performance et efficacité. Il affiche des performances écrasantes par rapport aux autres modèles, notamment dans les benchmarks de codage et de raisonnement.

| Benchmark | GLM-4.7-Flash | Qwen3-30B-Thinking | GPT-OSS-20B |

|---|---|---|---|

| AIME 25 | 91.6 | 85.0 | 91.7 |

| GPQA | 75.2 | 73.4 | 71.5 |

| SWE-bench (Verified) | 59.2 | 22.0 | 34.0 |

| τ²-Bench | 79.5 | 49.0 | 47.7 |

| BrowseComp | 42.8 | 2.29 | 28.3 |

| LCB v6 | 64.0 | 66.0 | 61.0 |

| HLE | 14.4 | 9.8 | 10.9 |

En particulier, sur le SWE-bench Verified qui évalue les compétences pratiques en codage, il a obtenu un score de 59,2, dépassant largement les modèles concurrents. Cela suggère que des agents de codage de niveau API commercial peuvent être exécutés même dans des environnements locaux.

2. Déploiement local de GLM-4.7-Flash (Serve Locally)

GLM-4.7-Flash peut être déployé localement via les frameworks d'inférence vLLM et SGLang. Actuellement, les deux frameworks prennent en charge ce modèle dans leurs branches principales. Les instructions de déploiement détaillées sont disponibles sur le dépôt GitHub officiel (zai-org/GLM-4.5).

3. Utilisation dans les environnements locaux et sur site

Cette vidéo démontre le processus d'exécution d'un modèle local via Ollama sur une seule RTX 3090, en supposant un environnement où l'utilisation d'API externes est difficile pour des raisons de sécurité ou de coût.

- Tâche effectuée : Un scénario commercial pratique évaluant un document de plan de développement pour un visualiseur/éditeur Markdown et dérivant les tâches suivantes.

- Résultat du test : Il a été confirmé que l'analyse de documents et la rédaction de guides de développement se déroulent sans problème, même sans connexion cloud.

4. Mise à jour Careti : Application de la Thinking UI

Dans la version actuellement distribuée, la connexion avec Ollama semblait parfois lente car le processus de réflexion (Thinking) du modèle n'était pas affiché à l'utilisateur.

- Patch prévu : Le Careti utilisé dans la vidéo est une version future patchée pour afficher le processus de Thinking.

- Amélioration : L'utilisateur pouvant vérifier en temps réel le processus par lequel le modèle organise sa logique en interne, la compréhension du flux de travail est facilitée et le temps d'attente perçu est amélioré.

5. Performance attendue par matériel (RTX 3090 vs 5090)

La vitesse de fonctionnement de la RTX 3090 dans la vidéo peut sembler un peu lente, ce qui est dû aux limites de la bande passante mémoire du matériel. Les différences de performance attendues lors de l'introduction future de la RTX 5090 sont les suivantes :

| Catégorie | RTX 3090 (Vidéo actuelle) | RTX 5090 (Prévu) |

|---|---|---|

| Vitesse d'inférence (TPS) | Env. 80 ~ 100 TPS | Env. 180 ~ 220 TPS |

| Bande passante mémoire | 936 Go/s | Plus de 1 792 Go/s |

| Capacité VRAM | 24 Go | 32 Go |

Lors de l'utilisation de la RTX 5090, une augmentation de la vitesse de plus de 2 fois est attendue grâce à l'augmentation de la bande passante, et la VRAM accrue sera avantageuse pour traiter des codes sources plus longs en une seule fois.

Nous espérons que cela fournira des données de référence substantielles pour ceux qui envisagent un environnement de développement d'IA local.

Plus d'articles

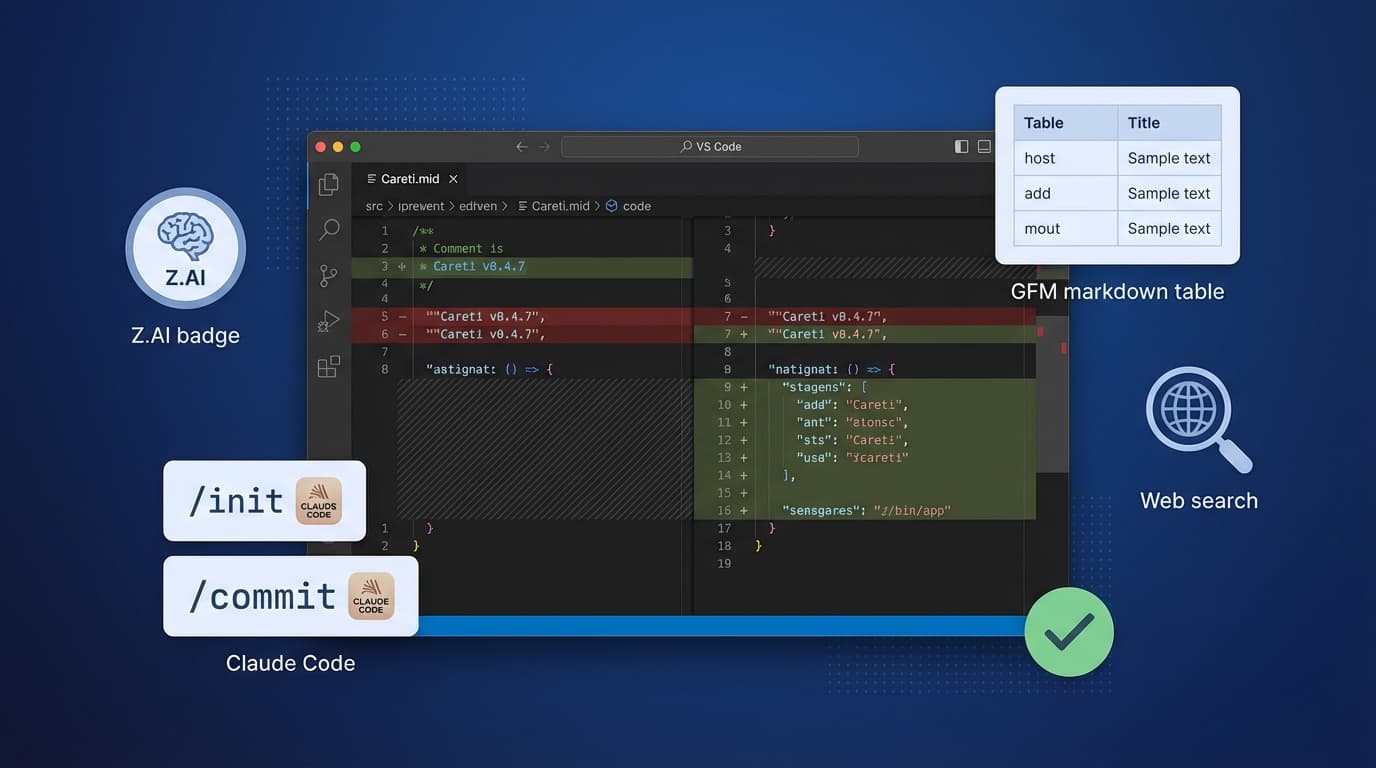

Careti v0.4.7 ajoute le modèle Z.AI GLM-4.7, un système de commandes compatible Claude Code, des améliorations SmartEditEngine et des améliorations d'interface.

Découvrez comment générer des images de cartes de tarot en utilisant le modèle Upstage Solar2 et la lecture de documents HWP dans K-Cursor Careti. Explorez les capacités uniques de traitement de documents et le flux de travail de génération d'images de Careti en tant que solution d'IA souveraine.