2 janv. 2026Luke

Caret NotebookLM : L'avenir de l'IA souveraine et de l'open source à travers les allégations concernant Solar 100B

À travers la discussion technique entourant le modèle Solar 100B d'Upstage, nous explorons la voie à suivre pour une véritable IA souveraine et l'importance de la vérification publique open source du point de vue de Caret en tant que compagnon d'IA de confiance.

Récemment, la communauté coréenne de l'IA a été animée par des discussions techniques concernant le modèle Solar 100B d'Upstage. Alors que des allégations ont émergé selon lesquelles le modèle était dérivé d'un modèle open source chinois, l'importance de la vérification technique est devenue plus importante que jamais.

Ce débat s'étend au-delà du modèle d'une seule entreprise, posant une question cruciale à nous tous : qu'est-ce qui constitue une véritable « IA souveraine », et pourquoi une alliance saine avec l'écosystème mondial de l'open source est-elle essentielle ? La promesse d'Upstage d'une réponse transparente et la participation volontaire de la communauté ont ouvert un forum pour un débat technique sain, favorisant la croissance collective de l'écosystème national de l'IA.

Pour approfondir ce sujet, chez Caret, nous avons produit deux vidéos à l'aide de Caret Notebook LM.

- Présentation :

- Discussion :

Les deux vidéos ont été créées à l'aide de notre projet open source NotebookLM to YouTube. Nous continuerons à partager les actualités connexes via le blog Caret.

Le point de vue de Caret : Vers un compagnon d'IA fiable

Bien sûr, il est difficile de comparer directement une entreprise qui construit des modèles massifs comme Upstage avec une startup comme la nôtre qui ne fait que faire ses premiers pas. Pour être franc, il pourrait même sembler que nous essayons simplement de sauter dans le train en marche de cette question brûlante. 😅

Cependant, en tant que créateurs d'un « compagnon d'IA » et en tant que développeurs qui utilisent l'IA quotidiennement, cette discussion résonne en nous à un niveau différent. Il s'agit d'un excellent exemple de l'importance de la « confiance » et de la « transparence » pour l'avancement de la technologie de l'IA, en particulier de l'IA souveraine, et de la manière dont un processus de vérification publique par le biais de la communauté peut favoriser un écosystème technologique sain.

C'est précisément pourquoi chez Caret, nous rêvons de créer un « compagnon d'IA co-évoluant » basé sur Cline, un open source dont la stabilité a été prouvée. Pour qu'une IA devienne le collègue le plus proche d'un développeur, elle doit avant tout être digne de confiance. Cette confiance ne peut être consolidée que par un processus transparent de divulgation du code source, d'évolution avec la communauté et de vérification continue.

Nous espérons que cette discussion transcende les différends improductifs et, à l'instar de l'engagement d'Upstage en faveur de la vérification publique, devienne une opportunité pour l'ensemble de l'écosystème national de l'IA de réaffirmer les valeurs de transparence et d'ouverture et de croître ensemble. En tant que membre de la communauté open source, Caret s'efforcera également de créer des outils et une culture qui contribuent à un écosystème technologique sain.

[Examen post-diffusion] Comment les « journaux » ont transformé toutes les allégations en preuves

Grâce à la diffusion de la vérification technique d'Upstage, toutes les allégations précédentes ont été étayées par des données et des journaux clairs. Vous pouvez regarder la diffusion complète sur le lien d'origine.

En tant que développeur, voici un résumé des principales preuves présentées dans la diffusion, expliquant pourquoi elles ont été décisives et comment les critiques initiales découlaient d'une incompréhension technique.

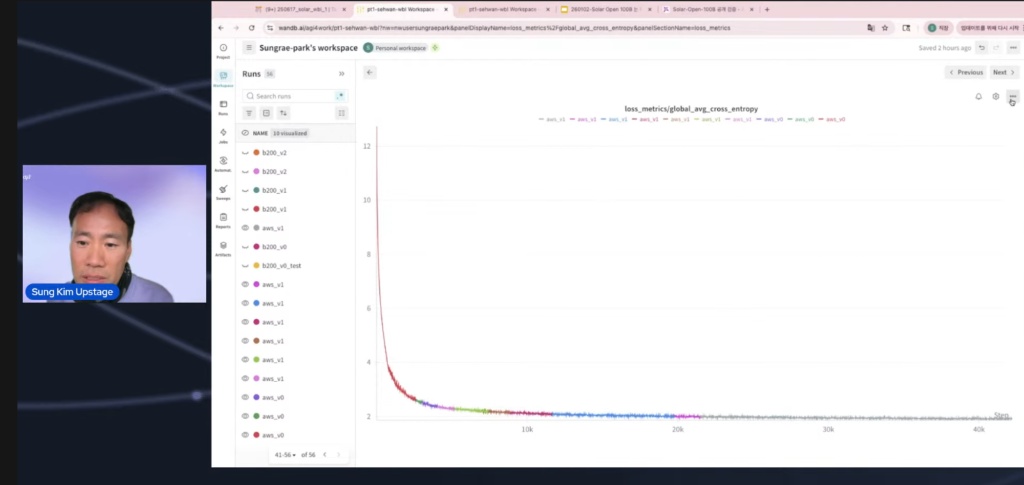

- Preuve décisive : Les graphiques des journaux de formation WandB confirment « À partir de zéro » La preuve la plus convaincante était le « graphique des journaux de formation WandB » qui enregistrait et visualisait l'ensemble du processus de formation du modèle. Le graphique partagé publiquement montrait clairement une courbe où la valeur de perte commençait à 12 dès le premier point de contrôle, puis chutait brusquement.

Ce que cela signifie : S'ils avaient affiné en important un point de contrôle à partir d'un modèle pré-entraîné, la perte initiale n'aurait pas pu être aussi élevée (elle commence généralement autour de 2-3).

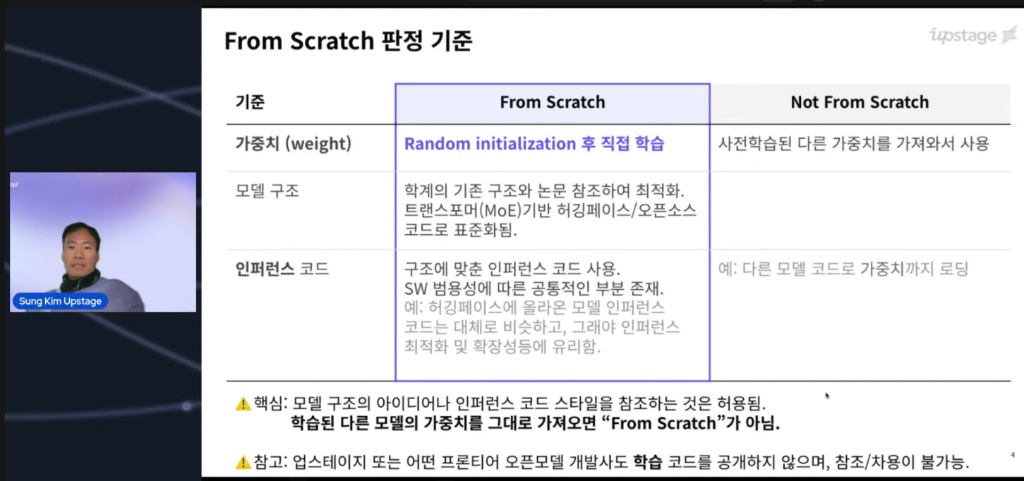

Le cœur de la controverse était la définition de « À partir de zéro ». Étant donné que beaucoup étaient confus par cette norme, la diffusion a commencé par la clarifier. Il a été précisé que le fait de commencer la formation à partir de zéro entraîne inévitablement une valeur de perte initiale très élevée.

À titre de preuve, ils ont révélé une capture d'écran du tableau de bord WandB qui enregistrait le processus de formation réel. L'image ci-dessous montre la valeur de perte initiale qui commence très haut, ce qui est une preuve physique solide que le modèle a commencé à apprendre à partir de zéro.

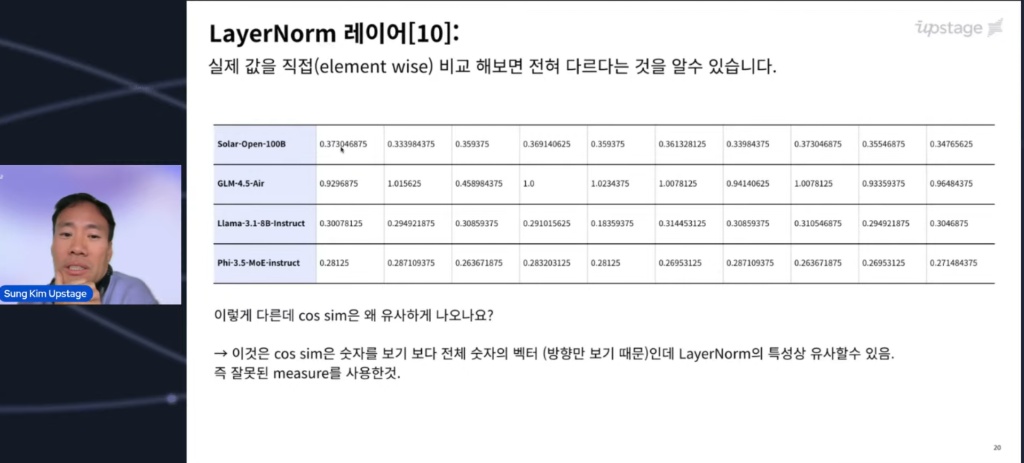

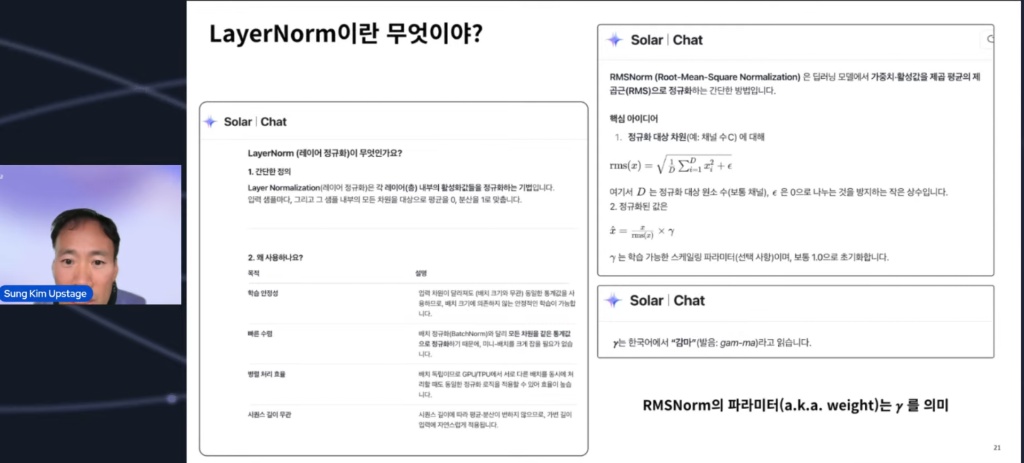

- Le piège de la « similitude » : Regarder la direction, pas l'ampleur Il a également été démontré pourquoi la « similitude cosinus », le point de départ des allégations, était une mesure imparfaite.

Limitation de la mesure : La similitude cosinus ne tient compte que de la « direction » des vecteurs. Si la même architecture (plan) est utilisée, les directions des vecteurs sont forcément similaires en raison des caractéristiques structurelles des couches.

Comparaison réelle : Lors de l'examen des poids élément par élément, l'échelle et les valeurs numériques spécifiques étaient complètement différentes. Il a confirmé le fait que « ce n'est pas parce qu'ils pointent tous vers l'étoile du Nord que ce sont les mêmes lampes de poche ».

(Pour une petite note amusante, les images ci-dessous contiennent un extrait de la conversation d'Upstage à l'époque, comme un petit « œuf de Pâques ». 😅)

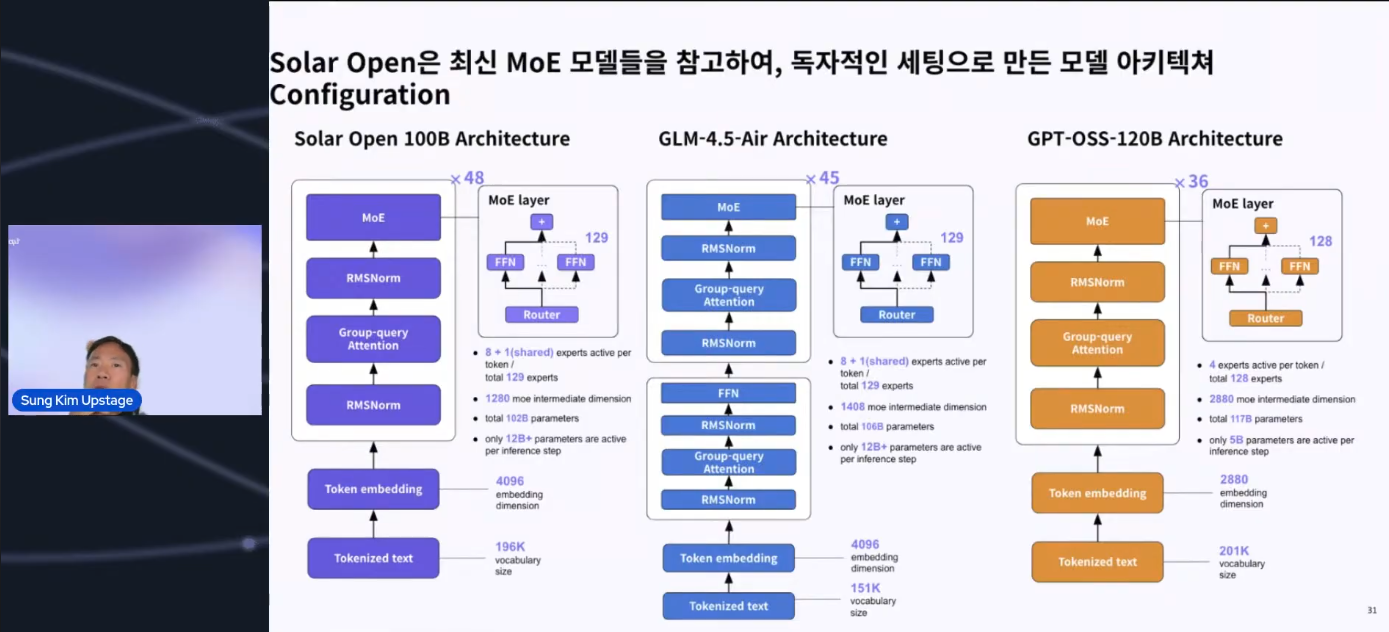

- Différenciation structurelle : Une « amélioration », pas une copie

Les caractéristiques structurelles ont également été clairement expliquées, montrant qu'il ne s'agissait pas d'un simple doublon.

Différences par rapport à GPT-OSS 120B : La structure a été renforcée en ajoutant des couches partagées pour une formation stable.

Différences par rapport à GPT-OSS 120B : La structure a été renforcée en ajoutant des couches partagées pour une formation stable.

Différences par rapport à GLM : Il a été confirmé que des décisions d'ingénierie et des optimisations indépendantes ont été prises, telles que la suppression audacieuse des couches denses jugées avoir peu d'impact sur les performances.

Conclusion Cette clarification a donné une grande crédibilité à la communauté des développeurs, car elle a été prouvée non pas par des appels émotionnels, mais par des données, des journaux et une architecture. En fin de compte, c'est un moment qui a réaffirmé la vérité selon laquelle « le code ne ment pas ».

Plus d'articles

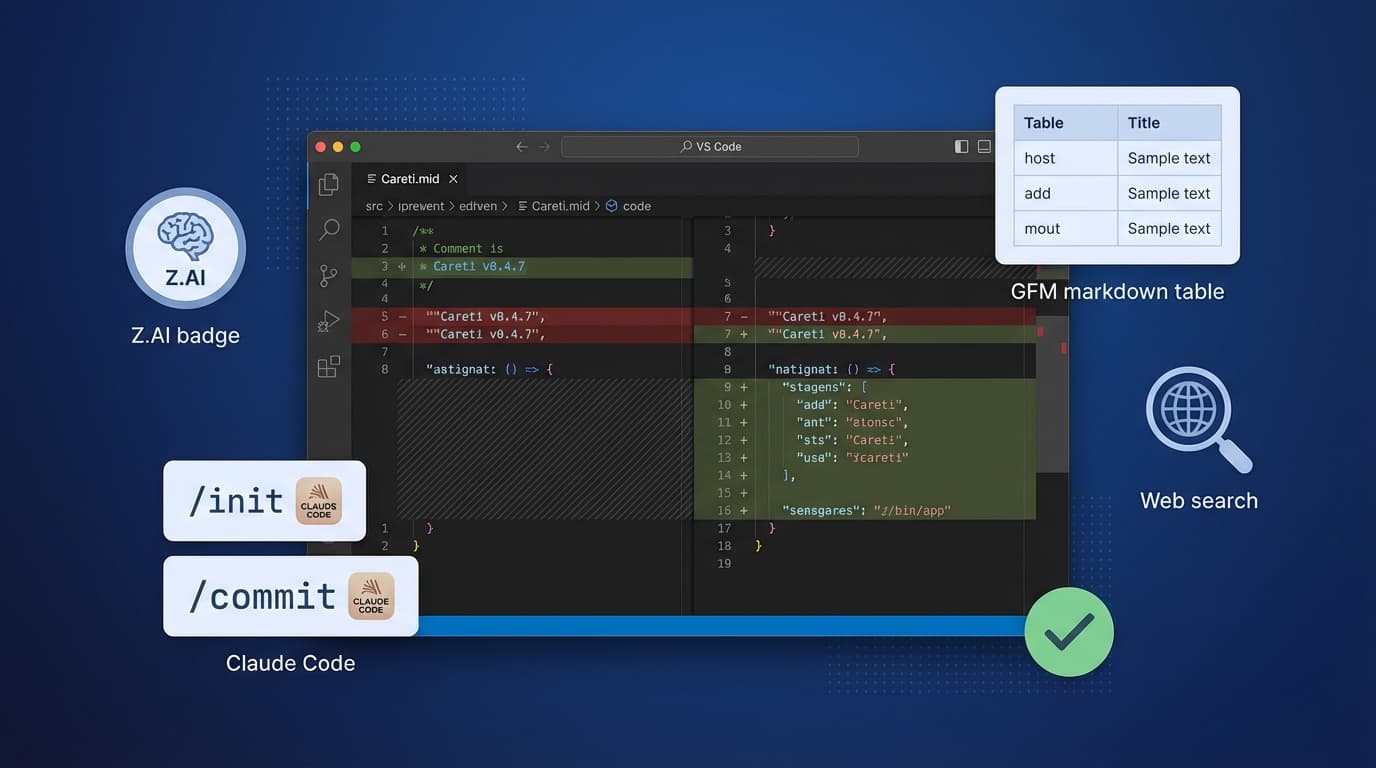

Careti v0.4.7 ajoute le modèle Z.AI GLM-4.7, un système de commandes compatible Claude Code, des améliorations SmartEditEngine et des améliorations d'interface.

Démo de GLM-4.7-Flash exécuté localement avec Ollama sur une RTX 3090 et mises à jour de l'interface Thinking UI. Découvrez des cas d'utilisation sur site pour résoudre les problèmes de sécurité et de coûts.