2026年1月24日Luke

Careti GLM-4.7-Flash 本地运行与私有化部署指南

在 RTX 3090 环境下使用 Ollama 本地运行 GLM-4.7-Flash 的演示以及 Thinking UI 的更新。请查看解决安全和成本问题的私有化部署案例。

随着近期大家对 GLM-4.7-Flash-Latest 模型的关注度提高,我们收到了许多关于 Careti 是否支持本地 LLM 和私有化(On-Premise)环境的咨询。我们准备了一段演示实际运行情况的视频。

1. 为什么选择 GLM-4.7-Flash?

GLM-4.7-Flash 是 30B 级别的佼佼者,这是一种在性能和效率之间取得平衡的新型轻量级部署选项(30B-A3B MoE)。特别是在编码和推理基准测试中,它表现出了优于其他模型的压倒性性能。

| Benchmark | GLM-4.7-Flash | Qwen3-30B-Thinking | GPT-OSS-20B |

|---|---|---|---|

| AIME 25 | 91.6 | 85.0 | 91.7 |

| GPQA | 75.2 | 73.4 | 71.5 |

| SWE-bench (Verified) | 59.2 | 22.0 | 34.0 |

| τ²-Bench | 79.5 | 49.0 | 47.7 |

| BrowseComp | 42.8 | 2.29 | 28.3 |

| LCB v6 | 64.0 | 66.0 | 61.0 |

| HLE | 14.4 | 9.8 | 10.9 |

特别是在评估实际编码能力的 SWE-bench Verified 中,它获得了 59.2 分,大幅领先于竞争模型。这表明即使在本地环境中,也可以运行商业 API 级别的编码代理(Coding Agent)。

2. 本地部署 GLM-4.7-Flash (Serve Locally)

GLM-4.7-Flash 可以通过 vLLM 和 SGLang 推理框架在本地部署。目前,两个框架的主分支均已支持该模型。详细的部署说明可以在官方 GitHub 仓库 (zai-org/GLM-4.5) 中找到。

3. 本地及私有化环境中的应用

本视频假设由于安全或成本问题而难以使用外部 API 的环境,记录了在单张 RTX 3090 环境下通过 Ollama 运行本地模型的过程。

- 执行任务:评估 Markdown 查看器/编辑器开发计划文档并导出后续任务的实际业务场景测试。

- 测试结果:确认即使在没有云连接的情况下,文档分析和开发指南编写也能顺利进行。

4. Careti 更新:应用 Thinking UI

在当前发布的版本中,与 Ollama 对接时感觉较慢的部分是因为模型的推理(Thinking)过程没有展示给用户。

- 补丁计划:视频中使用的 Careti 是已打补丁展示 Thinking 过程的未来版本。

- 改进点:用户可以实时查看模型在内部整理逻辑的过程,从而更容易掌握工作流程,并改善感知的等待时间。

5. 不同硬件的预期性能 (RTX 3090 vs 5090)

视频中 RTX 3090 的运行速度可能感觉稍慢,这是由于硬件显存带宽的限制。未来引入 RTX 5090 时预期的性能差异如下:

| 类别 | RTX 3090 (当前视频) | RTX 5090 (预期) |

|---|---|---|

| 推理速度 (TPS) | 约 80 ~ 100 TPS | 约 180 ~ 220 TPS |

| 显存带宽 | 936 GB/s | 1,792 GB/s 以上 |

| VRAM 容量 | 24GB | 32GB |

使用 RTX 5090 时,由于带宽增加,预计速度将提升约 2 倍以上,且增加的 VRAM 将更有利于一次性处理更长的源代码。

希望这能为正在考虑本地 AI 开发环境的各位提供实质性的参考数据。

更多文章

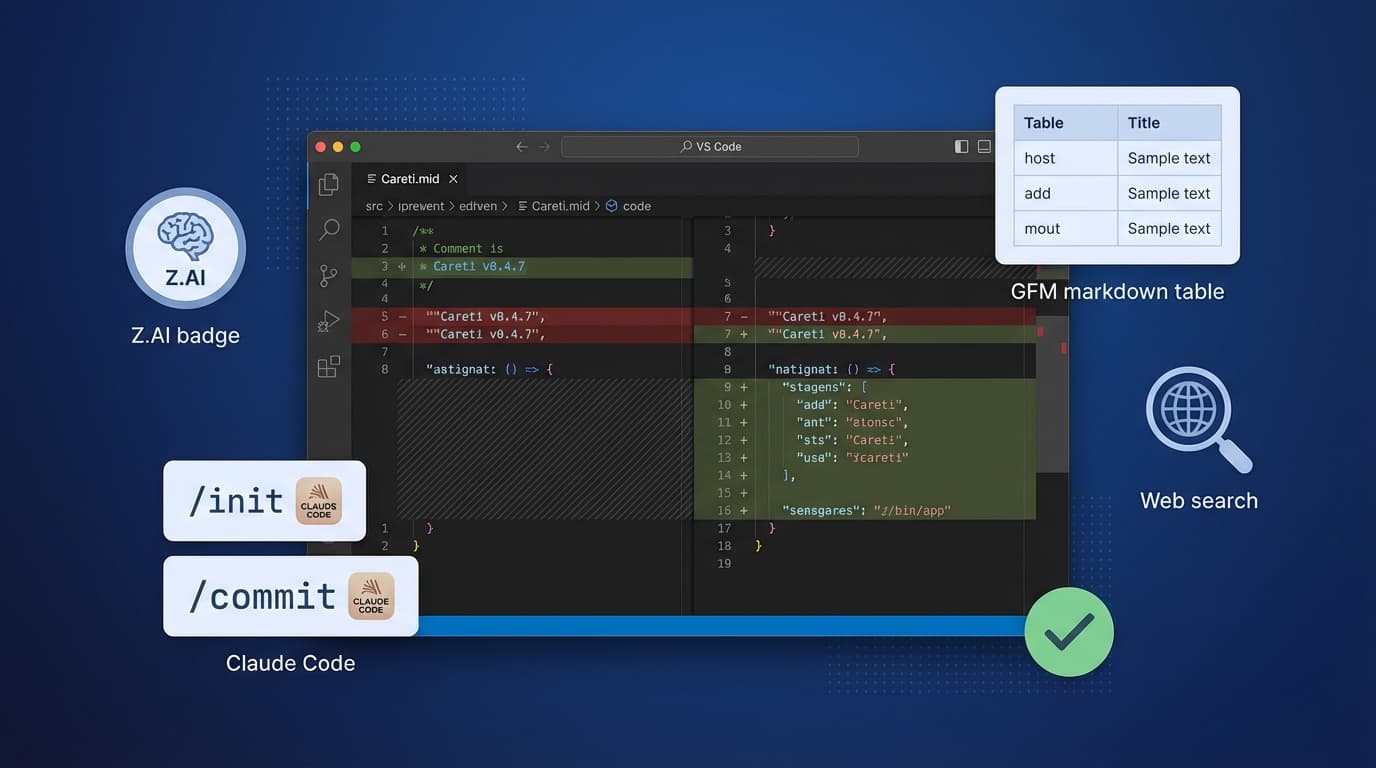

Careti v0.4.7添加了Z.AI GLM-4.7模型、Claude Code兼容命令系统、SmartEditEngine改进和UI增强。