24. Jan. 2026Luke

Careti GLM-4.7-Flash Guide für lokale Ausführung und On-Premise-Nutzung

Demo der lokalen Ausführung von GLM-4.7-Flash mit Ollama auf einer RTX 3090 und Updates zur Thinking UI. Entdecken Sie On-Premise-Anwendungsfälle zur Lösung von Sicherheits- und Kostenproblemen.

Angesichts des jüngsten Interesses am GLM-4.7-Flash-Latest-Modell haben wir viele Anfragen bezüglich der Unterstützung von Careti für lokale LLMs und On-Premise-Umgebungen erhalten. Wir haben ein Video vorbereitet, das den tatsächlichen Betrieb zeigt.

1. Warum GLM-4.7-Flash?

GLM-4.7-Flash ist führend in der 30B-Klasse und eine neue, leichte Bereitstellungsoption (30B-A3B MoE), die ein Gleichgewicht zwischen Leistung und Effizienz herstellt. Insbesondere bei Coding- und Reasoning-Benchmarks zeigt es eine überragende Leistung im Vergleich zu anderen Modellen.

| Benchmark | GLM-4.7-Flash | Qwen3-30B-Thinking | GPT-OSS-20B |

|---|---|---|---|

| AIME 25 | 91.6 | 85.0 | 91.7 |

| GPQA | 75.2 | 73.4 | 71.5 |

| SWE-bench (Verified) | 59.2 | 22.0 | 34.0 |

| τ²-Bench | 79.5 | 49.0 | 47.7 |

| BrowseComp | 42.8 | 2.29 | 28.3 |

| LCB v6 | 64.0 | 66.0 | 61.0 |

| HLE | 14.4 | 9.8 | 10.9 |

Insbesondere im SWE-bench Verified, der praktische Programmierfähigkeiten bewertet, erzielte es 59,2 Punkte und ließ damit Konkurrenzmodelle weit hinter sich. Dies deutet darauf hin, dass Coding-Agenten auf kommerziellem API-Niveau auch in lokalen Umgebungen ausgeführt werden können.

2. Lokale Bereitstellung von GLM-4.7-Flash (Serve Locally)

GLM-4.7-Flash kann lokal über die Inferenz-Frameworks vLLM und SGLang bereitgestellt werden. Beide Frameworks unterstützen das Modell derzeit in ihren Main-Branches. Detaillierte Bereitstellungsanweisungen finden Sie im offiziellen GitHub-Repository (zai-org/GLM-4.5).

3. Nutzung in lokalen und On-Premise-Umgebungen

Dieses Video demonstriert den Prozess der Ausführung eines lokalen Modells über Ollama auf einer einzelnen RTX 3090, gedacht für Umgebungen, in denen die Nutzung externer APIs aus Sicherheits- oder Kostengründen schwierig ist.

- Durchgeführte Aufgabe: Ein praktisches Geschäftsszenario, bei dem ein Entwicklungsplandokument für einen Markdown-Viewer/-Editor bewertet und Folgeaufgaben abgeleitet werden.

- Testergebnis: Es wurde bestätigt, dass Dokumentenanalyse und die Erstellung von Entwicklungsleitfäden auch ohne Cloud-Verbindung reibungslos funktionieren.

4. Careti-Update: Einführung der Thinking UI

In der aktuell verteilten Version fühlte sich die Verbindung mit Ollama teilweise langsam an, da der Denkprozess (Thinking) des Modells für den Benutzer nicht sichtbar war.

- Geplanter Patch: Das im Video verwendete Careti ist eine zukünftige Version, die so gepatcht wurde, dass der Thinking-Prozess angezeigt wird.

- Verbesserung: Da der Prozess, in dem das Modell intern seine Logik ordnet, in Echtzeit überprüft werden kann, wird das Verständnis des Arbeitsablaufs erleichtert und die gefühlte Wartezeit verbessert.

5. Erwartete Leistung nach Hardware (RTX 3090 vs 5090)

Die Betriebsgeschwindigkeit der RTX 3090 im Video mag etwas langsam erscheinen, was auf die Grenzen der Speicherbandbreite der Hardware zurückzuführen ist. Die erwarteten Leistungsunterschiede bei einer zukünftigen Einführung der RTX 5090 sind wie folgt:

| Kategorie | RTX 3090 (aktuelles Video) | RTX 5090 (erwartet) |

|---|---|---|

| Inferenzgeschwindigkeit (TPS) | ca. 80 ~ 100 TPS | ca. 180 ~ 220 TPS |

| Speicherbandbreite | 936 GB/s | über 1.792 GB/s |

| VRAM-Kapazität | 24 GB | 32 GB |

Bei Verwendung der RTX 5090 wird aufgrund der erhöhten Bandbreite eine mehr als doppelte Geschwindigkeitssteigerung erwartet, und der vergrößerte VRAM wird vorteilhaft für die Verarbeitung längerer Quellcodes in einem Durchgang sein.

Wir hoffen, dass dies nützliche Daten für alle sind, die eine lokale AI-Entwicklungsumgebung in Betracht ziehen.

Weitere Beiträge

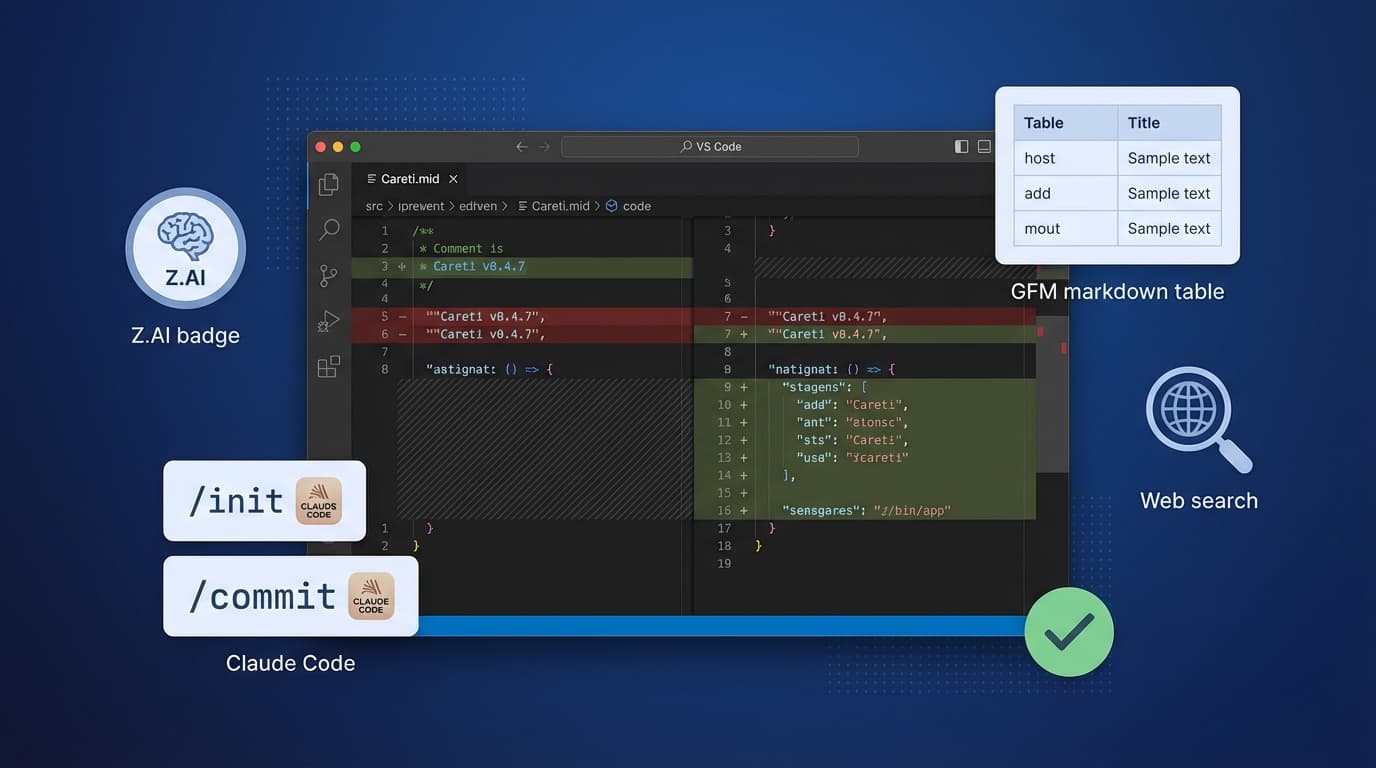

Careti v0.4.7 fügt das Z.AI GLM-4.7 Modell, Claude Code kompatibles Befehlssystem, SmartEditEngine Verbesserungen und UI-Erweiterungen hinzu.

Erfahren Sie, wie Sie mit dem Upstage Solar2-Modell und der HWP-Dokumentenlesefunktion in K-Cursor Careti Tarotkarten-Bilder generieren. Entdecken Sie Caretis einzigartige Dokumentenverarbeitungsfähigkeiten und den Bildgenerierungs-Workflow als souveräne KI-Lösung.