2026年1月24日Luke

Careti GLM-4.7-Flash ローカル実行およびオンプレミス活用ガイド

RTX 3090環境でOllamaを使用したGLM-4.7-Flashのローカル実行デモとThinking UIのアップデートについて。セキュリティとコストの問題を解決するためのオンプレミス環境での活用事例をご確認ください。

最近のGLM-4.7-Flash-Latestモデルへの関心に伴い、CaretiのローカルLLMおよびオンプレミス環境サポートに関するお問い合わせを多くいただいております。実際の動作を示すビデオを用意しました。

1. なぜ GLM-4.7-Flash なのか?

GLM-4.7-Flashは30Bクラスのリーダーであり、パフォーマンスと効率のバランスをとった新しい軽量展開オプション(30B-A3B MoE)です。特にコーディングと推論のベンチマークにおいて、他のモデルと比較して圧倒的なパフォーマンスを発揮します。

| Benchmark | GLM-4.7-Flash | Qwen3-30B-Thinking | GPT-OSS-20B |

|---|---|---|---|

| AIME 25 | 91.6 | 85.0 | 91.7 |

| GPQA | 75.2 | 73.4 | 71.5 |

| SWE-bench (Verified) | 59.2 | 22.0 | 34.0 |

| τ²-Bench | 79.5 | 49.0 | 47.7 |

| BrowseComp | 42.8 | 2.29 | 28.3 |

| LCB v6 | 64.0 | 66.0 | 61.0 |

| HLE | 14.4 | 9.8 | 10.9 |

特に、実践的なコーディング能力を評価するSWE-bench Verifiedで59.2点を記録し、競合モデルを大きく引き離しています。これは、ローカル環境でも商用APIレベルのコーディングエージェントを実行できることを示唆しています。

2. ローカルでの展開 (Serve GLM-4.7-Flash Locally)

GLM-4.7-Flashは、vLLMおよびSGLang推論フレームワークを通じてローカルに展開可能です。現在、両方のフレームワークがメインブランチでサポートしています。詳細な展開手順は、公式GitHubリポジトリ(zai-org/GLM-4.5)で確認できます。

3. ローカルおよびオンプレミス環境での活用

今回のビデオは、セキュリティやコストの問題で外部APIの使用が難しい環境を想定し、RTX 3090単一環境でOllamaを通じてローカルモデルを実行する過程を収録しています。

- 実行タスク: マークダウンビューアエディタ開発計画文書を評価し、後続タスクを導き出す実務シナリオテスト。

- テスト結果: クラウド接続なしでも文書分析および開発ガイド作成が円滑に進むことを確認しました。

4. Careti アップデート: Thinking UI 適用

現在配布されているバージョンでOllama連携時に遅く感じられた部分は、モデルの推論(Thinking)プロセスがユーザーに見えていなかったためです。

- パッチ予定事項: ビデオで使用されたCaretiは、Thinkingプロセスが露出するようにパッチされた次期バージョンです。

- 改善点: モデルが内部的に論理を整理する過程をリアルタイムで確認できるため、作業フローの把握が容易になり、体感待ち時間も改善されました。

5. ハードウェア別の予想パフォーマンス (RTX 3090 vs 5090)

映像内のRTX 3090の動作速度はややゆっくり感じられるかもしれませんが、これはハードウェアのメモリ帯域幅の限界によるものです。今後RTX 5090を導入した場合に期待できるパフォーマンス差は以下の通りです。

| 区分 | RTX 3090 (現在の映像) | RTX 5090 (予想) |

|---|---|---|

| 推論速度 (TPS) | 約 80 ~ 100 TPS | 約 180 ~ 220 TPS |

| メモリ帯域幅 | 936 GB/s | 1,792 GB/s 以上 |

| VRAM 容量 | 24GB | 32GB |

RTX 5090を使用する場合、帯域幅の増加により約2倍以上の速度向上が予想され、増えたVRAMのおかげで、より長いソースコードを一度に処理するのに有利になります。

ローカルAI開発環境を検討中の方々にとって、実質的なデータとなれば幸いです。

More posts

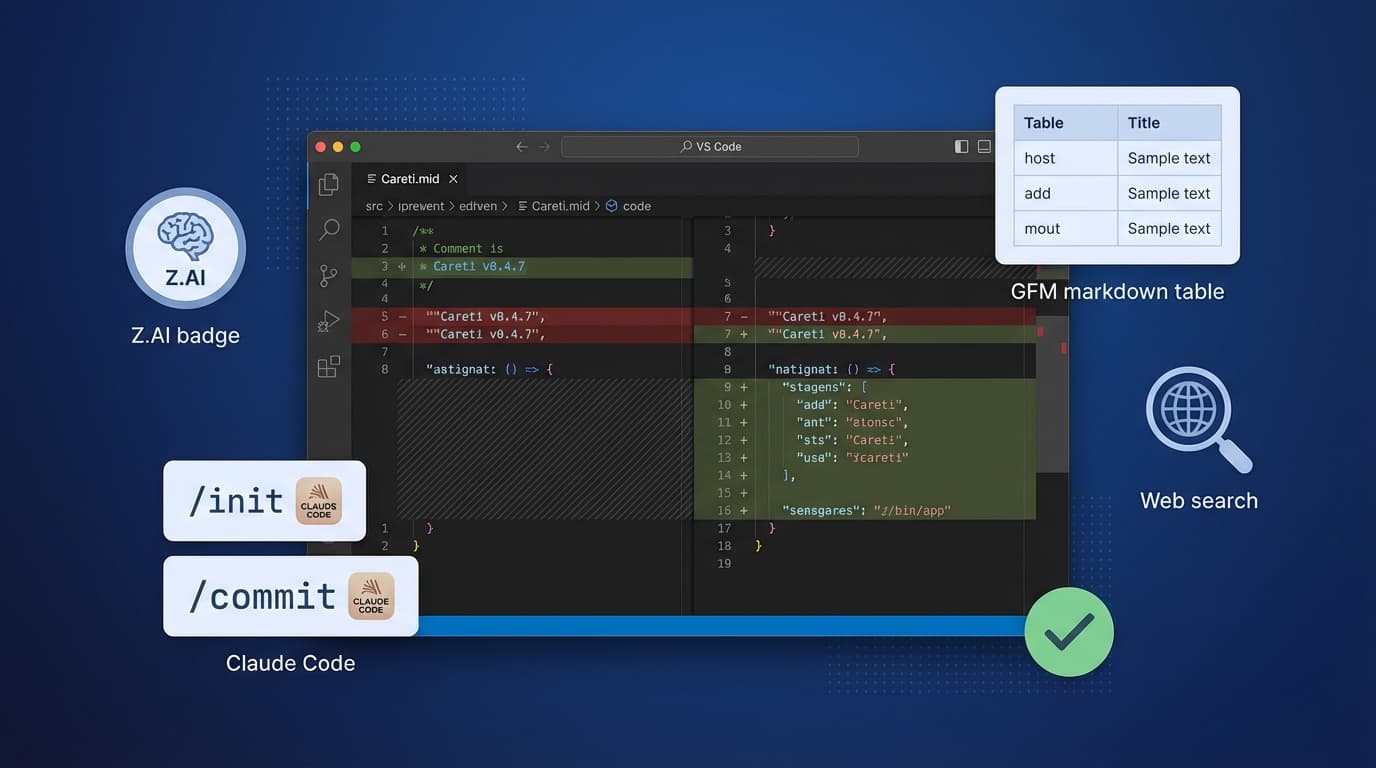

Careti v0.4.7でZ.AI GLM-4.7モデル、Claude Code互換コマンドシステム、SmartEditEngine改善、UI改善を追加しました。